「顔認識技術は有害だ」「顔認識技術の利用を禁止せよ」──このような声が米国で高まっている。巨大テクノロジー企業の米IBM、Amazon、Microsoftは相次ぎ警察など法執行機関への顔認識技術の提供を中止すると発表した。

「顔認識技術は有害」との表現に抵抗を感じる読者もいるかもしれない。「技術それ自体は善でも悪でもない」と考えるのが従来の常識だったからだ。だが時代は変わり、情報技術は大規模適用されて社会に影響を及ぼしている。いまや技術と倫理・人権の距離は非常に近い。機械学習に基づく顔認識技術には人種差別、性差別が組み込まれており、使い方によっては社会から排除されがちな人々をより脆弱(ぜいじゃく)な立場に追いやる危険性が指摘されている。

引き金を引いたのは、2020年5月25日に米ミネアポリスでアフリカ系アメリカ人ジョージ・フロイド氏が、警官官に首を押さえつけられ死亡した事件だ。人種差別に反対する運動が広がり、人種差別の要素を持つ技術への批判も高まった。以前から顔認識技術は「人種差別、性差別を助長する」との批判があった。事件を機に大手テクノロジー企業が顔認識技術の提供中止に追い込まれた形だ。

事件以前から、米国の複数の自治体は警察の顔認識技術の利用を禁止していた。19年5月に米サンフランシスコ市、同年6月にマサチューセッツ州ソマービル市、7月にカリフォルニア州オークランド市、12月にはマサチューセッツ州ブルックライン市が禁止している。サンディエゴ市は20年1月、利用停止を決議した。今では米国の連邦政府として顔認識技術を規制する法整備の取り組みが動いている。

なぜ、これほどまでに顔認識技術への批判が高まっているのか。

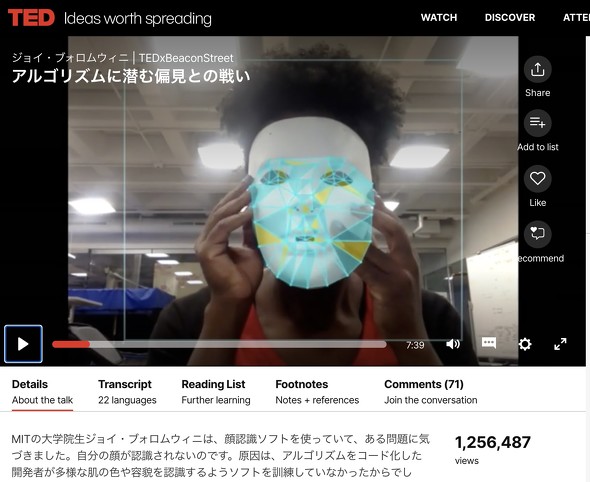

アフリカ系アメリカ人女性の大学院生ジョイ・ブォロムウィニ氏は、顔認識ソフトが自分の顔を認識してくれないことに気がつく。だが「白いお面」を付けることで同じソフトは「顔である」と認識した(「TEDxBeaconStreet」より)

アフリカ系アメリカ人女性の大学院生ジョイ・ブォロムウィニ氏は、顔認識ソフトが自分の顔を認識してくれないことに気がつく。だが「白いお面」を付けることで同じソフトは「顔である」と認識した(「TEDxBeaconStreet」より)顔認識にひそむ人種差別、性差別

画像を使って人間の顔を識別する技術「顔認識(facial recognition)」には長い歴史があるが、最近になってその問題点が指摘されるようになった。

1点目に、顔認識技術は市民の監視に利用されやすい。米国の警察は人口の半数をカバーする顔画像データベースを持っているといわれている。街頭の監視カメラやソーシャルメディアで流通した写真などと付き合わせれば、簡単に個人を特定されるおそれがある。

2点目に、米国の警察はアフリカ系アメリカ人などマイノリティを標的にしがちな傾向があるといわれている。顔認識技術の利用は、差別されている人々を「より脆弱(ぜいじゃく)な立場」に追いやるために使われる可能性がある。

3点目に、白人男性に比べて、アフリカ系アメリカ人やアメリカ先住民族に対する顔認識技術の認識率は低く、誤検出の可能性が高い。このため警察による誤認逮捕などに結びつくおそれがある。

このように、顔認識技術は個人のプライバシーを侵害する懸念が高く、人種差別、性差別を固定化し拡散する性質があると考えられている。

ここで疑問を持つ読者もいるかもしれない。中国では17年にアント・フィナンシャルが顔認識で決済できるサービスを店舗に導入した(関連記事)。日本では、19年12月から大阪メトロが顔認識(顔認証)を使った自動改札機の実証実験を始めている。こうした顔認識技術の有用性に注目した取り組みについてはどう考えればいいのだろうか。

米国での論調は非常に厳しい。「顔認識技術は有用性より有害性がはるかに上回る危険な技術である」と強く主張する論文も出ている。大規模監視と、脆弱な人々をより脆弱な立場に追いやり格差を固定する性質があることから、機械学習に基づく顔認識技術そのものが批判されているのだ。関連して、19年11月に米紙New York Timesが報道した、中国ウイグル自治区の少数民族弾圧で顔認識技術が使われた事実も、顔認識技術そのものへの懸念につながっている。

関連記事

顔認識の人種差別、性差別の傾向を実証

顔認識への批判の早期の事例として、16年に開かれたイベント「TEDxBeaconStreet」でのスピーチを見てみたい。ガーナにルーツを持つアフリカ系アメリカ人女性の大学院生ジョイ・ブォロムウィニ(Joy Buolamwin)氏は、顔認識ソフトが自分の顔を認識してくれないことに気がつく。だが「白いお面」を付けることで同じソフトは「顔である」と認識したのだ。

このときスピーチしたブォロムウィニ氏は、現在はMIT Media Labの「Gender Shades」と呼ぶ研究グループのリーダーだ。同グループが18年に発表した研究成果は、顔認識技術の差別性を示す結果としてよく引用される。IBM、Face++、Microsoftの3社の顔認識ソフトウェアを比較し、「明るい肌の男性」はエラー率0.8%なのに対し、「暗い肌の女性」はエラー率が34.7%に及ぶことを示したのである。最も格差が大きいのはIBMの製品だった。

これは、アフリカ系アメリカ人女性にとって深刻なことだ。人種、性差で認識率に大きく格差がある顔認識技術を警察が使い始めると、誤認逮捕される可能性が高くなってしまう。

18年7月、人権団体のACLU(アメリカ自由人権協会)は顔認識技術に関する印象深い調査結果を公表した(発表資料)。Amazonの顔認識技術「Rekognition」を使い、犯罪者が逮捕された時に撮影される顔画像2万5000枚と、米国の上院議員、下院議員の公開写真と照合するテストを行った結果、米国の28人の議員を「犯罪者と同一人物である」(偽陽性)と判定したのである。米議員の中で非白人は20%しかいないが、誤認識された議員の40%は非白人だった。Amazon製品が白人以外の認識率が悪いことを、印象的な形で明らかにした調査といえる。ACLUは、「Amazonは政府機関に顔認識ソフトを提供するべきではない」と主張した。

その後、より大規模な調査が出た。19年12月、米国の国立研究所NIST(米国標準技術研究所)は189種類の顔認識ソフトを評価し、1対1マッチングでほとんどの顔認識システムはアジア人やアフリカ系米国人に対して、白人より10〜100倍も誤認識率が高かったと報告した。

関連記事

IBM、Amazon、Microsoftが相次ぎ顔認識技術の提供を中止

米IBMは6月8日、フロイド氏の死亡事件を受けて「汎用の顔認識ソフトウェアから撤退する」と発表した(発表資料)。この発表は政策提言の形を取っており、その柱は(1)警察改革、(2)テクノロジーの責任ある利用、(3)教育支援の3つだ。ここで「テクノロジーの責任ある利用」とは、IBMにとっては「汎用の顔認識技術」の提供を中止することだった。IBMの顔認識技術は前述した「Gender Shades」の調査結果で最も人種・性の格差が大きかった。

米Amazonは6月10日、同社の顔認識ソフトウェアの警察での利用を1年停止すると発表した(発表資料)。同社は「政府が顔認識技術の倫理的な使用を管理するために、より強い規制を設けるべき」としており、1年の間に顔認識技術への適切な規制が打ち出されることを期待する発表文面となっている。Amazonの顔認識技術は、前述のACLUによる調査で人種差別的と名指しされていた。

米Microsoftのプレジデントを務めるブラッド・スミス氏は、6月11日に米紙Washington Postが開催したライブイベントで、「顔認識技術を1年間は法執行機関(警察など)に提供しない」と明らかにした(関連記事)。スミス氏は、18年に「顔認識技術の規制を推進するべきだ」と唱えている。

Googleの「倫理的AIチーム」共同リーダーを務めるティムニット・ゲブル(Timnit Gebru)氏は、「現状では、顔認識は禁止するべきだ」と述べた(関連記事)。ゲブル氏は東アフリカのエルトリアにルーツを持つアフリカ系アメリカ人女性で、前述のMIT Media Labの研究グループ「Gender Shades」のメンバーでもある。前出のブォロムウィニ氏と共同研究を行っている。

人権団体アムネスティは激しく非難

6月11日、人権団体アムネスティ・インターナショナルは「顔認識を禁止せよ」との声明を出した。「顔認識技術は、黒人コミュニティを標的とした警察による人権侵害を悪化させる可能性がある」と指摘する。特に、直近のジョージ・フロイド氏殺害事件を機に高まった人種差別撤廃運動の参加者への取り締まりのために「顔認識を使うな」と主張する。平和的なデモ活動の参加者には匿名で参加する権利があり、警察が顔認識技術を濫用することはこの権利の侵害にあたると指摘した。

この声明の背後にはある文脈がある。アムネスティは以前から顔認識技術が人権侵害につながると警告し、産業界の対応が鈍いと批判してきたのだ。

18年、アムネスティと人権団体Access Nowが共同で公表した「トロント宣言」は、機械学習(ML)技術が差別を固定、拡散する懸念を警告したものだ。アムネスティは19年に、このトロント宣言に対するテクノロジー企業の対応が鈍いことに失望する声明を発表している。この声明では、テクノロジー企業がAI倫理に関するチームを組織する一方で、顔認識の禁止のような具体的な取り組みが進まないことに対して、「倫理ウォッシング」であると強く非難している。倫理ウォッシングとは「倫理問題に取り組んでいるふりをしているだけで、具体的な動きを見せていない」との批判の意味が込められた言葉だ。

この声明から1年たって、大手テクノロジー企業IBM、Amazon、Microsoftはジョージ・フロイド氏殺害時件後の世論の高まりを受けて顔認識技術の提供を中止する事態に追い込まれたわけだ。

前述したように、顔認識技術は、大規模監視に使われる可能性が高く、社会的に排除されがちな人々をより脆弱な立場に追いやる形で利用される可能性が高く、人種差別や性差別が組み込まれている懸念が高い。もはや「技術自体は善でも悪でもない」とはいえない。

先に引用したアムネスティの批判や今回の大手ベンダーの動きを見ても分かるように、法整備が進まない状態では、倫理や人権に関わる問題は企業の自主的な取り組みだけではなかなか解決しない。日本の産業界もこの問題と無縁なままではいられないだろう。顔認識技術に伴う倫理面の課題を検討し、必要な場合には顔認識技術の利用の一時中止(モラトリアム)など強い措置を打ち出せる組織を設け、倫理面の検討を進めるべきだ。

筆者:星 暁雄

早稲田大学大学院理工学研究科修了。1986年日経マグロウヒル社(現・日経BP社)に入社。『日経エレクトロニクス』『日経Javaレビュー』などで記者、編集長の経験を経て、2006年からフリーランスのITジャーナリスト。IT領域全般に興味を持ち、特に革新的なソフトウェアテクノロジー、スタートアップ企業、個人開発者の取材を得意とする。最近はFinTech、ブロックチェーン、暗号通貨、テクノロジーと人権の関係に関心を持つ。

関連記事

"技術" - Google ニュース

June 17, 2020 at 05:00AM

https://ift.tt/3d61VNa

「顔認識技術を禁止せよ」 黒人差別を受けハイテク大手の対応は? - ITmedia

"技術" - Google ニュース

https://ift.tt/2FomjtX

Shoes Man Tutorial

Pos News Update

Meme Update

Korean Entertainment News

Japan News Update

Bagikan Berita Ini

0 Response to "「顔認識技術を禁止せよ」 黒人差別を受けハイテク大手の対応は? - ITmedia"

Post a Comment